依据西湖大学官微的资讯,近日发布关于《AI学习的底层逻辑是什么?来自物理学家的年末作答》的文章,自主选拔在线团队第一时间进行更新,一起来看。

AI学习的底层逻辑是什么?来自物理学家的年末作答

纵观2025,AI无疑是贯穿全球的核心关键词。

这一年,AI从技术狂热迈向深度落地:原生多模态架构成为主流,人形机器人开始量产,微软BioEmu-1模型用生成式AI重塑蛋白质功能研究……一系列突破正在重塑技术边界与社会生产生活方式。

面对这股智能浪潮,不同领域的专家有什么样的解读?计算机专家聚焦算力、数据与模型架构的协同优化,追求更高精度与速度;生命科学家好奇 AI 如何像“人类大脑”一样思考学习;哲学家则通过AI反思意识、自由意志与伦理边界 ——AI 的本质究竟是什么?

而在物理学家眼中,AI又是什么模样?答案或许藏在复杂系统的底层规律里 ——就像他们研究宇宙膨胀、粒子运动那样,AI的“黑箱”中,同样闪烁着等待被发现的普适性物理法则。

2年的最后一天,让我们聚焦一项来自西湖大学理学院、交叉科学中心汤超团队在人工智能神经网络学习机理的科研突破——研究团队通过统计物理学的视角,首次发现并解释了神经网络训练过程中的一个普适特征:参数更新的分布呈现一致的重尾(Heavy-tailed)幂律特性。研究进一步证明,这种复杂的动力学行为并非偶然,而是源于一种信息驱动的自组织(Information-driven self-organization)过程。

相关成果以“Heavy-tailed update distributions arise from information-driven self-organization in nonequilibrium learning”为题在线发表于PNAS《美国国家科学院院刊》上。西湖大学理学院、交叉科学中心博士后张昕亚为第一作者。西湖大学理学院讲席教授、交叉科学中心主任汤超教授为通讯作者。

探索还是约束,这是一个问题

当探索与约束之间达到了某种平衡,会导致自组织临界态的出现,其特征就是幂律,即在双对数坐标下呈现线性关系(简单解释为一条直线),并体现出无特征尺度与重尾分布的统计特征。

01 当我们利用AI翻译文章,看智能推荐的视频时,你是否会好奇这些能读懂世界的人工智能,是如何学会这些技能的?

这离不开人工智能背后的“支柱”——神经网络。

自1943年首个数学神经元模型提出以来,神经网络凭借模仿人类大脑结构的设计,已能处理复杂的机器学习任务。但长期以来,它始终是个神秘的“黑箱”。我们知道输入数据后能得到精准输出,却看不清内部参数调整、知识积累的底层逻辑。以往研究多关注网络的初始参数和最终模型,却忽略了中间最关键的“参数更新过程”—— 这恰恰是AI从“无知”到“精通”的核心环节。

“人工智能的学习过程,其实和人类做决策有很多相似之处。”文章第一作者、西湖大学汤超团队博士后张昕亚解释道。就像年轻人求职时,既要广泛投递简历、探索各种可能性,又要考虑自身能力、行业前景等现实约束。神经网络在“学习”时也面临着同样的权衡:既要在庞大的空间中随机探索,找到更优的参数配置,又要受任务目标约束,不能偏离学习方向。

这种权衡,正是复杂系统中“自组织临界性”的经典特征。

汤超教授身上有一个很有特色的标签——学科交叉,他在统计物理、复杂系统、物理生物学、系统生物学等领域做了许多开创性工作,多年来着力用物理学思想及方法研究生物问题,探索生命系统中的定量规律和设计原理。1987年,他与合作者提出自组织临界性科学思想,其核心特征是微小扰动即可引发不同规模的雪崩事件,且事件规模的时空分布呈现幂律规律。

什么是自组织临界态?著名的“沙堆模型”形象地说明了这个临界态的形成和特点——

在一个平地上缓缓倾倒沙粒,一个沙堆逐渐形成。随着沙堆高度的增加,坡度也不断增加,沙堆发生坍塌的可能也随之变大。一定时候,沙堆的坡度达到一个临界值,新添加一粒沙子就可能引起沙崩。这时的沙堆系统就是处于“自组织临界态”,且临界态时沙崩的大小与其出现的频率呈幂律关系。

事实上,这种平衡在自然界屡见不鲜。地震的能量分布遵循幂律,小地震发生频繁,大地震发生的间隔更长;大脑中神经元的连接也是少数强连接支撑核心功能,多数弱连接保障灵活调整。

这一研究基础,为回答AI学习机理提供了关键视角。

受这些物理和生物系统的启发,研究团队将目光投向非平衡学习条件下的人工神经网络训练过程——它的学习过程是否也处于某种“临界态”?

AI的“权衡”——信息驱动自组织

“好比登山,探险家可以自由选择登上的路线,但不能偏离最终方向。”文章第一作者张昕亚比喻道。当这两种力量达到一种平衡时,会让神经网络的参数更新既不会盲目探索,也不会陷入局部最优解无法自拔。

02 为了解答这问题,研究团队开展了一场覆盖多种场景的系统性实验。

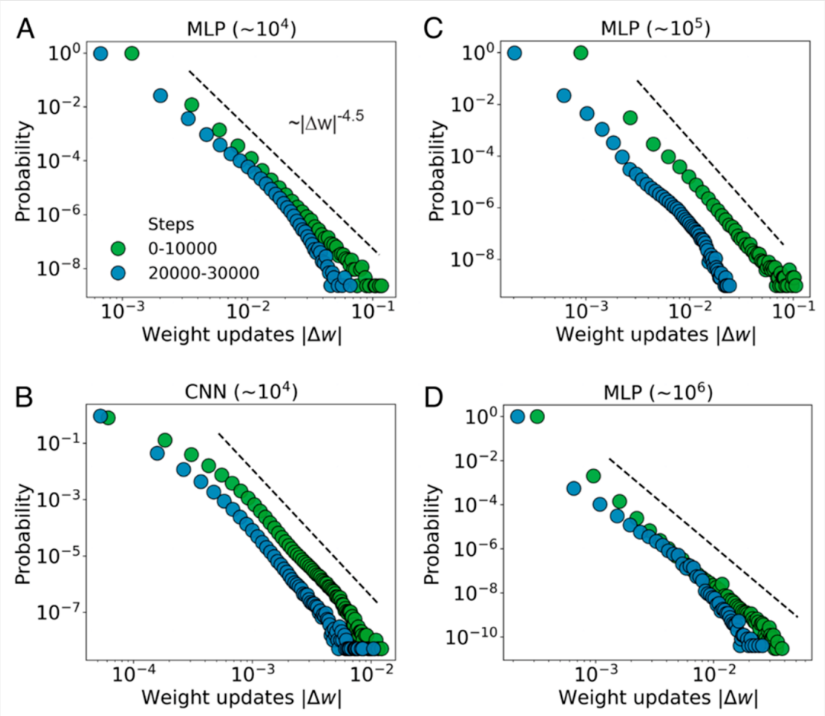

他们选取了当前主流的三类神经网络架构 —— 多层感知机(MLP)、卷积神经网络(CNN)、Transformer,测试了不同参数量级的模型,用到了多种数据集,还覆盖了训练初期和后期等不同进程。

实验结果显示,无论换哪种模型、哪种数据、哪个训练阶段,神经网络的参数更新幅度分布始终呈现重尾特征,遵循幂律形式。简单来说,参数更新绝大多数时候是小调整,偶尔会出现大变动。在改变小批量大小、学习率、损失函数、激活函数、权重初始化方式等多种训练配置下,这种分布依然稳定存在。

这说明它不是某种训练技巧带来的偶然现象,而是基于梯度学习的神经网络的本质属性。就像不管地震在何时何地发生,都会呈现“小地震发生频繁,大地震发生的间隔更长”的特征,这是由地震发生的本质决定的。

图1. 不同模型、规模和训练阶段下的参数重尾分布。(A)参数量为104的多层感知机(MLP),其中绿色和蓝色分别代表训练快速损失下降的早期阶段和接近收敛的后期阶段(B)参数量为104的卷积神经网络(CNN)。(C, D)分别是参数量为105和106的MLP模型。

为什么不同的神经网络都会呈现这种“重尾分布”规律呢?

团队构建了一个基于第一性原理的理论框架,最终揭开了谜底,这一切源于神经网络学习过程中的“信息驱动自组织”。

这个框架的核心是两个原理的竞争与平衡:最大熵原理和互信息约束。

最大熵原理代表了神经网络的自由探索。在没有额外约束时,它会保持最大程度的无偏性,在解空间中随机探索各种可能性,在没有额外约束时倾向于探索更大的范围。

互信息约束则是限制了神经网络的探索。它会引导参数更新与任务目标相关性的方向靠拢,这确保学习过程不是盲目探索,而是有目标导向的。

结合费希尔信息矩阵的标度行为和路径积分方法,研究团队从理论上推导出参数更新分布自然呈现幂律形式,其指数由互信息约束强度和梯度方向性共同决定。这一理论推导与实验数据吻合,证实了“信息驱动自组织”是重尾分布的根本原因。

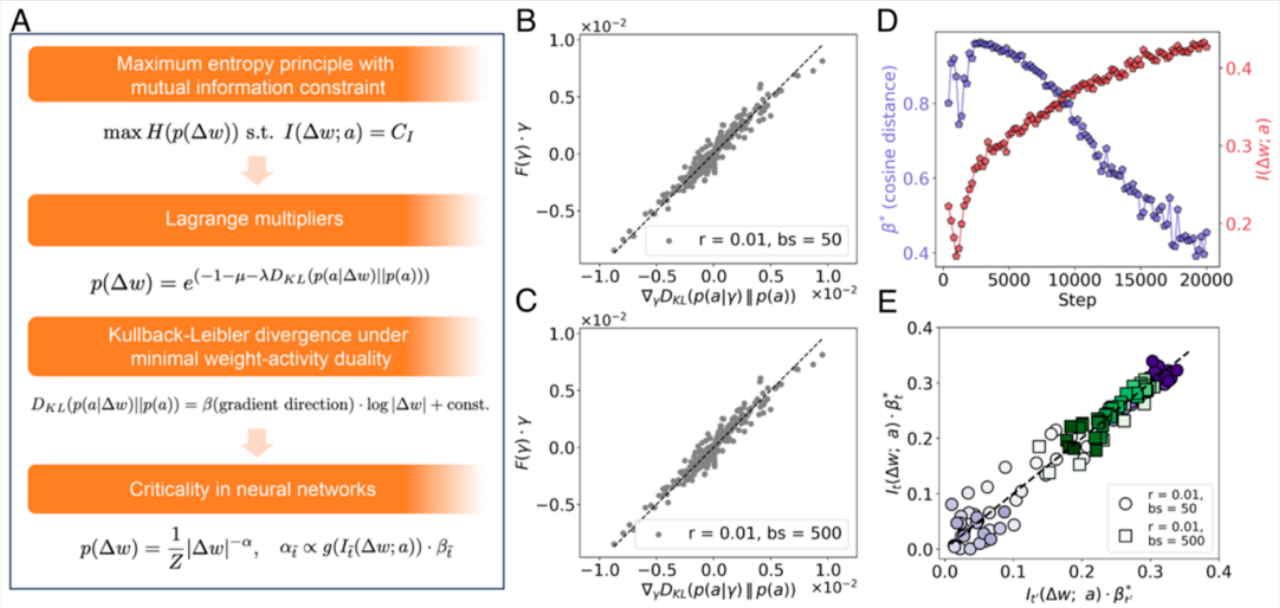

图2. 重尾幂律更新分布出现的理论框架和数值验证。(A)理论框架基于最大熵和互信息约束。(B, C)局部二次逼近的数值验证。(D)梯度方向的代替量与互信息在训练过程中的变化。(E)估计的幂律指数在逐步训练间隔的变化。

为进一步验证自组织机制的存在,研究团队从两个维度展开深入分析:

1、多尺度的损失景观

扰动实验显示,小扰动下,损失变化呈指数衰减,说明局部是“平坦的盆地”,小调整不会影响性能;大扰动下,损失变化立刻转为幂律形式,意味着全局呈现无标度特性,也就是说不管观察哪个范围的参数变化,损失变化的核心规律都不变。这种“局部平坦、全局无标度”的多尺度地形,正是神经网络能稳定学习又能灵活探索的关键,进一步印证了自组织机制的存在。

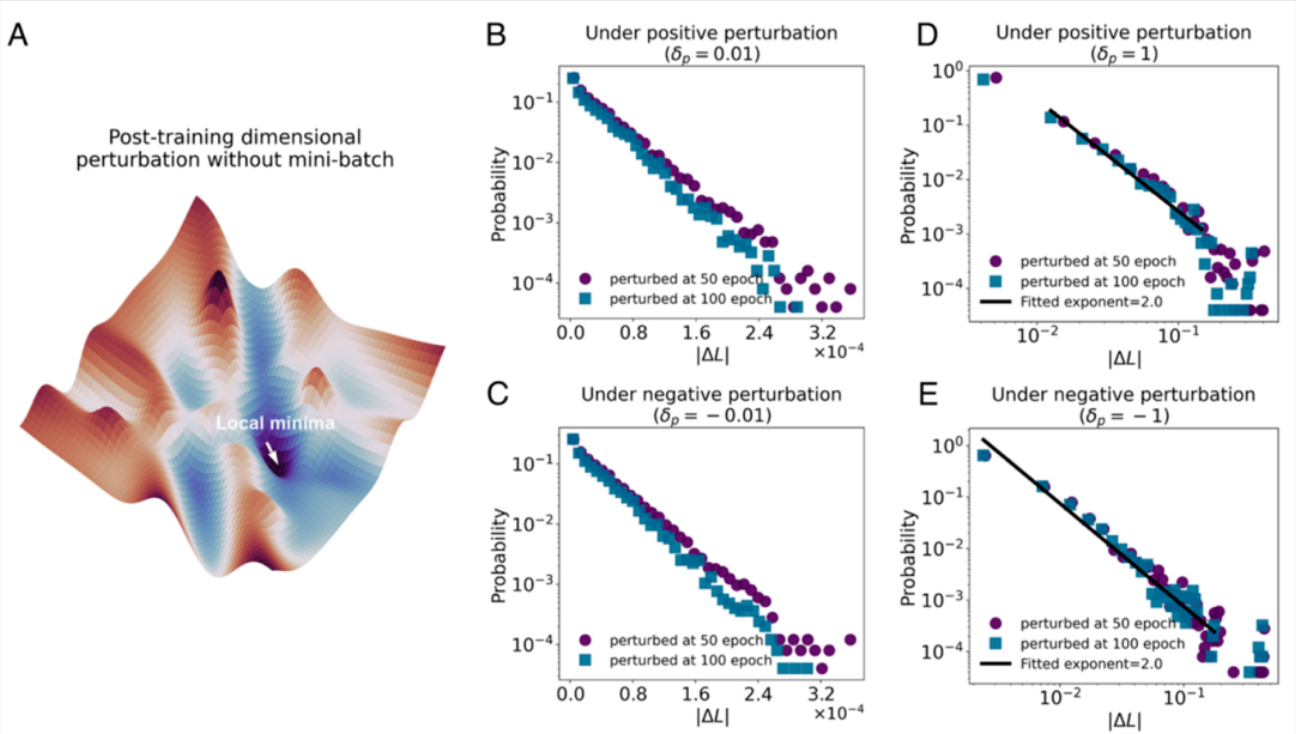

图3:模型训练后的损失景观扰动分析。(A)损失景观的示意图。(B, C)在小扰动下,损失变化的概率呈类指数衰减,反映局部极小值附近的平坦性。(D, E)大扰动下则表现为幂律行为,幂律拟合得指数约为2.0。

2、大更新事件的时间标度律

更有趣的是,团队发现 AI的大幅参数更新的时间间隔也遵循重尾分布,幂律指数约为2.5-2.7,与地震活动、神经元雪崩等临界系统的数值高度吻合。这意味着AI的学习并非平滑推进,而是以“突发式跃迁”为主导。突破性进展往往成群出现,如同“雪崩”,进一步证明其训练过程是典型的非平衡自组织动力学。

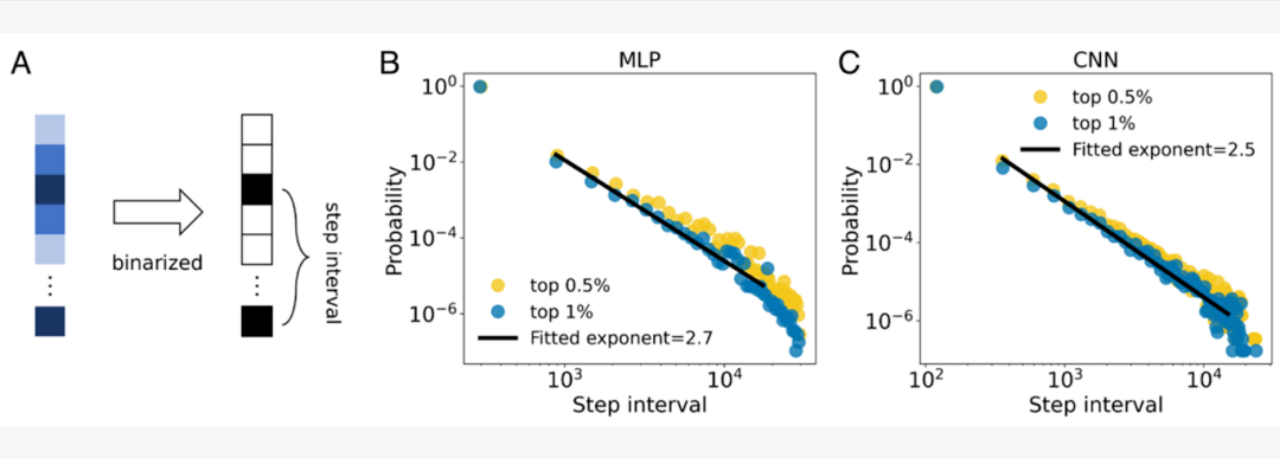

图4:大更新事件的时间标度律。(A)提取大更新事件的时间间隔的图形描述。(B, C)分别为MLP和CNN模型下的时间间隔分布,幂律拟合指数分别约为2.7和2.5。

打开“黑箱”的一把钥匙

这项研究提供了理论和数值证据,证明神经网络学习展现出信息驱动的自组织特性,其特征是重尾更新和时间聚集动力学。

03 汤超团队的研究,首次证实了神经网络学习的自组织特性,为破解AI“如何思考”的“黑箱”找到了关键一把钥匙。AI的学习不是杂乱无章的参数调整,而是遵循明确规律的自组织过程,这为我们设计更具解释性的AI系统提供了理论基础。

或许,我们未来可以根据这一规律,监控参数更新的分布特征,实时判断模型的学习状态,甚至针对性优化训练策略,比如通过调节互信息约束强度,让AI 在“探索”与“聚焦”间达到更优平衡。而基于这一机制设计的AI,可能会变得更聪明、更有逻辑,在训练效率和决策可靠性上实现双重提升。

人工智能的发展,不仅需要工程层面的技术迭代,更需要基础科学层面的机理探索。下一步,研究团队将继续深入研究这种自组织机制与模型性能的关联,尝试将理论发现转化为实际的训练优化方法。

这场跨越AI与统计物理的研究,不仅解答了AI学习背后的秘密,也让我们看到了复杂系统背后统一的科学规律。这一视角的研究表明,无论是大脑神经元的连接、地震的发生,还是AI的学习,复杂系统的自组织过程都可能遵循相似的幂律规律。这种跨学科的洞察,有望推动更多领域的交叉创新。

“人工智能的飞速发展和巨大成功带来了许多深刻的科学问题。”汤超说。当一把把打开AI“黑箱”的钥匙被发现,或许,我们可以期待下一个更可靠、更透明、更智能的AI时代的到来。

实验室介绍

西湖大学汤超实验室致力于解决复杂和生命系统中的核心科学问题。通过理论、计算、实验和数据驱动的方法开展跨学科研究,涵盖数学、物理、生命科学和人工智能。

实验室网站:

https://tangc.lab.westlake.edu.cn/